Micron HBM3E chokerer SK hynix med NVIDIA H200 AI GPU

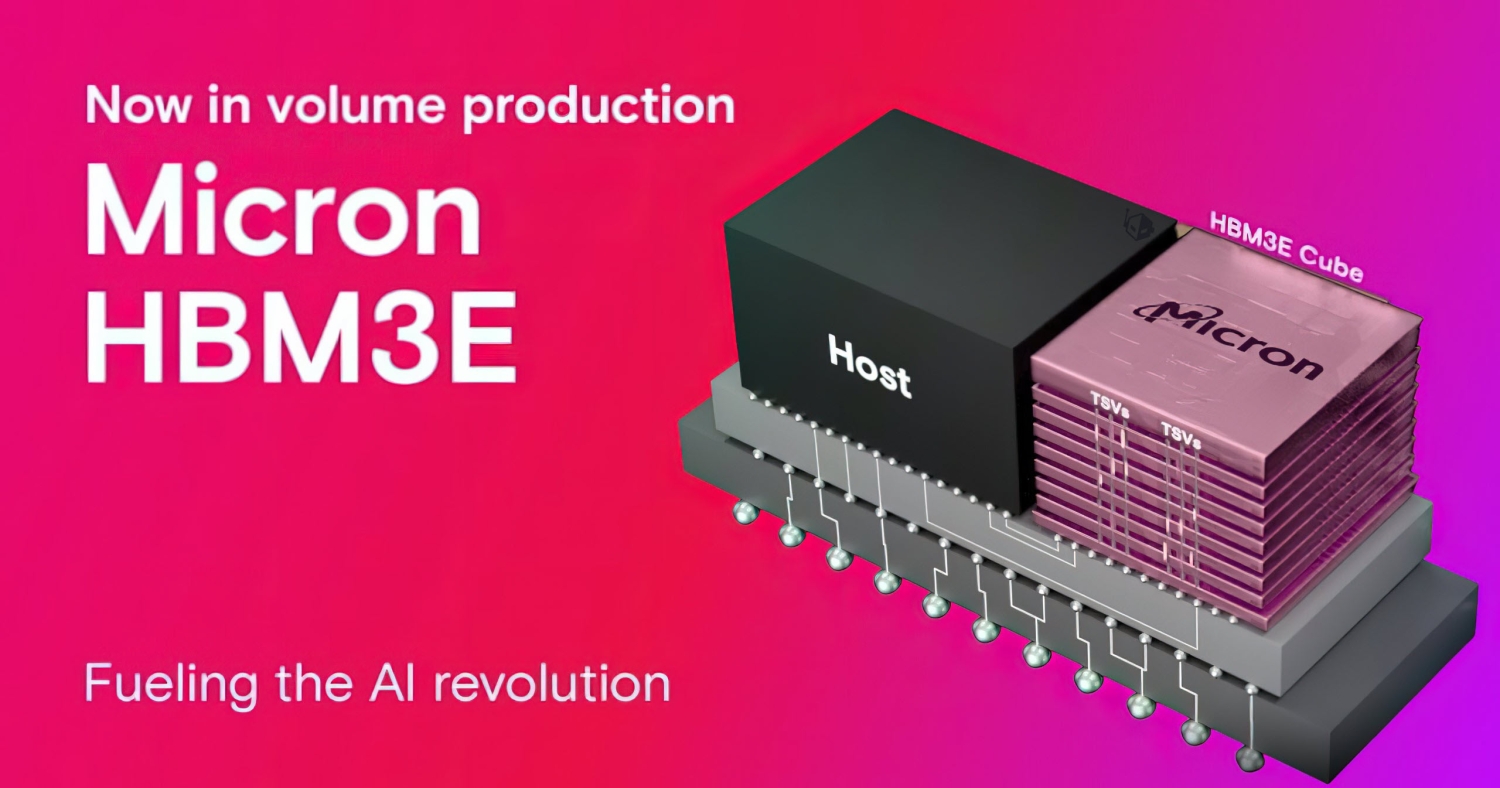

Micron var den første til at annoncere masseproduktionen af deres nye ultra-hurtige HBM3E-hukommelse i februar 2024, hvilket placerede firmaet foran HBM-rivalerne SK hynix og Samsung. Det amerikanske hukommelsesselskab annoncerede, at de ville levere HBM3E-hukommelseschips til NVIDIAs kommende H200 AI GPU, der vil have HBM3E-hukommelse, modsat sin forgænger med H100 AI GPU, der havde HBM3-hukommelse.

Micron vil fremstille deres nye HBM3E-hukommelseschips på deres 1b nanometer DRAM-chips, sammenlignelige med 12nm-noder, som HBM-lederen SK Hynix bruger på deres HBM. Ifølge Korea JoongAng Daily er Micron "teknisk foran" HBM-konkurrenten Samsung, der stadig bruger 1a nanometer teknologi, hvilket svarer til 14nm teknologi.

Microns nye 24GB 8-Hi HBM3E-hukommelse vil være hjertet i NVIDIAs kommende H200 AI GPU, og Microns overlegenhed i HBM-processen er en væsentlig del af deres aftale med NVIDIA. Micron forklarer deres nye HBM3E-hukommelse:

- Overlegen ydeevne: Med pinhastighed på over 9,2 gigabit pr. sekund (Gb/s) leverer Microns HBM3E mere end 1,2 terabyte pr. sekund (TB/s) hukommelsesbåndbredde, hvilket muliggør lynhurtig dataadgang for AI-akseleratorer, supercomputere og datacentre.

- Ekstraordinær effektivitet: HBM3E fører an i branchen med ~30% lavere strømforbrug sammenlignet med konkurrerende tilbud. For at understøtte den stigende efterspørgsel og brug af AI tilbyder HBM3E maksimal gennemstrømning med de laveste niveauer af strømforbrug for at forbedre vigtige driftsøkonomiske nøgletal for datacentre.

- Problemfri skalerbarhed: Med 24 GB kapacitet i dag giver HBM3E datacentre mulighed for problemfrit at skalere deres AI-applikationer. Uanset om det drejer sig om at træne massive neurale netværk eller fremskynde inferensopgaver, giver Microns løsning den nødvendige hukommelsesbåndbredde.

Eksperten inden for chips, Jeon In-seong, og forfatter til "The Future of the Semiconductor Empire" sagde: "Det er bevist, at Microns fremstillingsmetode er mere avanceret end Samsung Electronics, fordi deres HBM3E vil blive lavet med 1b nanometer teknologi. Micron vil have brug for noget mere arbejde på packaging, men det burde være lettere end det, de allerede har opnået med 1b nanometer teknologi".

Seneste ram

-

08 augram

-

07 augram

Nvidia godkender Samsungs 8-lags HBM3E-chips

-

06 augram

Samsung præsenterer tyndeste LPDDR5X DRAM

-

05 augram

SK hynix fokuserer på avanceret HBM chips

-

SK Hynix lancerer 60% hurtigere GDDR7

-

01 julram

Huawei, Wuhan Xinxin udvikler høj-båndbredde chips

-

28 junram

SK Hynix fremskynder HBM-plan

-

17 junram

AI fremmer lokal chip efterspørgsel i Kina