Apple AI køres på Google Chips

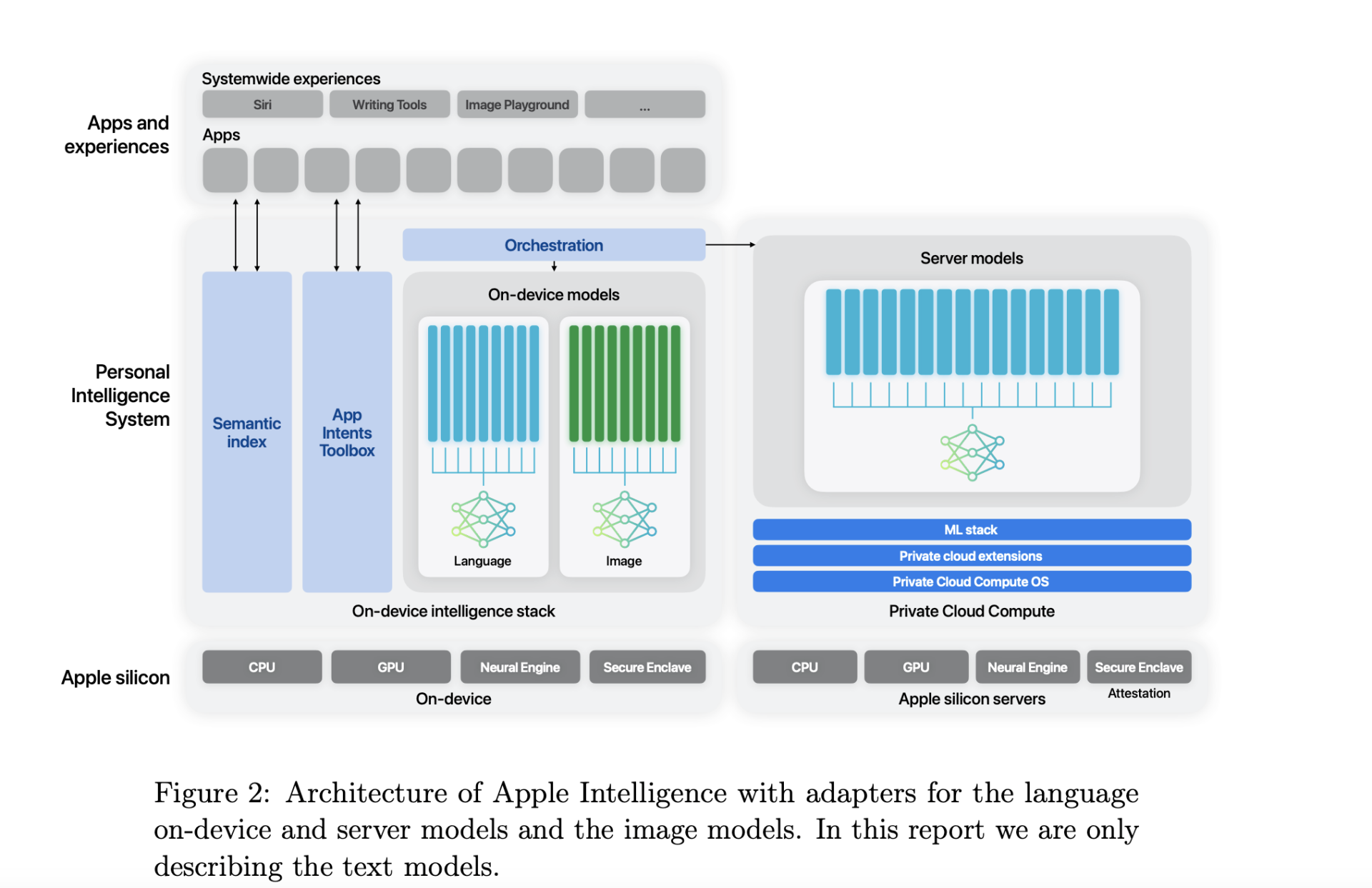

I et nyt forskningspapir, der beskriver sine AI-træningskapaciteter for iPhone og andre produkter, ser det ud til, at teknologigiganten Apple har valgt at stole på Googles chips frem for markedslederen NVIDIA's. I papiret deler Apple, at dens 2,73 milliarder parametre Apple Foundation Model (AFM) benytter v4 og v5p tensor processing unit (TPU) cloud-klynger leveret af Alphabet Inc.'s Google.

Apple afslører, at det træner en 6,3 billion token AI-model "fra bunden" på "8192 TPUv4 chips". For on-device AI-modeller, der bruges til funktioner som skrivning og billedvalg, benytter Apple en model på 6,4 milliarder parametre, trænet på 2048 TPU v5p chips.

Andre detaljer i papiret inkluderer evaluering af modellen for skadelige svar, følsomme emner, faktuel korrekthed, matematisk ydeevne og menneskelig tilfredshed med modellens output. Ifølge Apple fører AFM-server og on-device-modeller branchen i undertrykkelse af skadelige outputs.

For eksempel havde AFM-serveren en skadelig outputovertrædelsesrate på 6,3% sammenlignet med OpenAI's GPT-4, som havde en rate på 28,8%. Tilsvarende havde on-device AFM en overtrædelsesrate på 7,5% sammenlignet med Llama-3-8B's score på 21,8%.

For opsummering af e-mails, beskeder og notifikationer havde on-device AFM en tilfredshedsprocent på henholdsvis 71,3%, 63% og 74,9%. Forskningspapiret delte, at disse ledede over Llama-, Gemma- og Phi-3-modellerne.