NVIDIA RTX Series Architecture

NVIDIA Turing arkitekturen beskrevet!

NVIDIA har holdt kortene tæt ind til kroppen, og indtil i dag, onsdag den 19. september 2018, har vi gået spændt og ventet på at finde ud af, hvad NVIDIA havde oppe i ærmet til os med de nye RTX 2080(Ti) kort.

Arkitekturen

Den nye NVIDIA arkitektur, som vi finder i de nye RTX kort, har fået navnet Turing. En arkitektur, der bringer både Artificial Intelligence (AI) og det længe ventede og hypede Real-Time Raytracing med sig. Store og geniale fremskridt i den grafiske del af PC-verdenen, som er bygget til at give os som brugere en helt fænomenal spiloplevelse. I hvert fald hvis vi skal tro på NVIDIA. Hvad der rent faktisk kommer ud af det, må vi vente at se, når spilproducenterne får det implementeret.

Med lanceringen af RTX kortene og Turing arkitekturen har der også fra Microsofts side været godt kan i udviklingen. De har nemlig lanceret DirectML teknologien til AI rendering og DirectX Raytracing (DXR) API's, som spiludviklerne kan bruge til at få netop RTX funktionen med ind i spilverdenen.

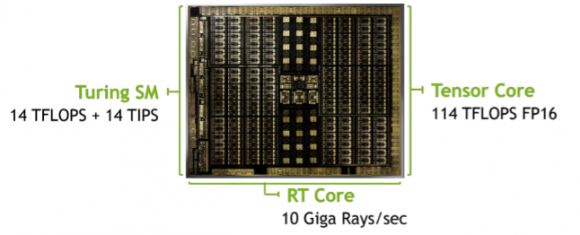

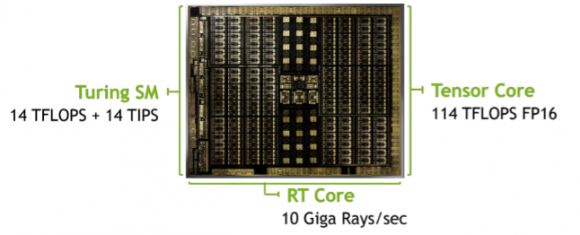

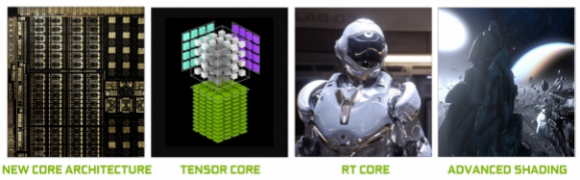

Turing arkitekturen bringer selvfølgelig også masser af ny teknologi med sig i form af nye RT cores, flere Tensor Cores og helt ny og avanceret shading teknologi, der skal give gamere verden over sublim grafik med GeForce RTX kortene, mens udviklere overalt kan nyde performance uden sammenligning til grafiske opgaver med Quadro RTX 6000 kortene.

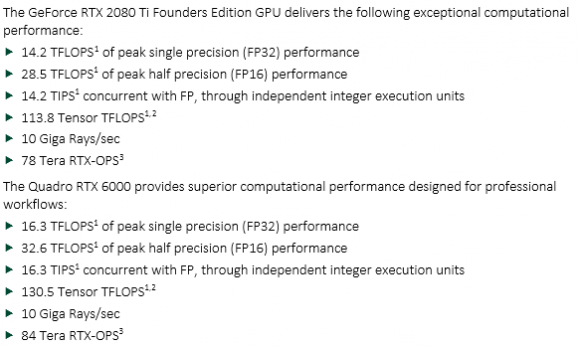

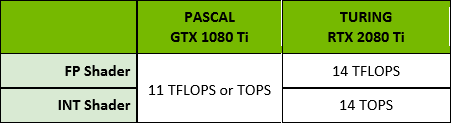

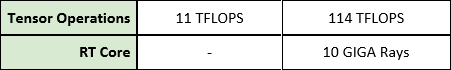

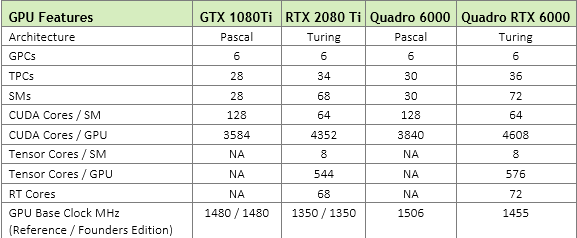

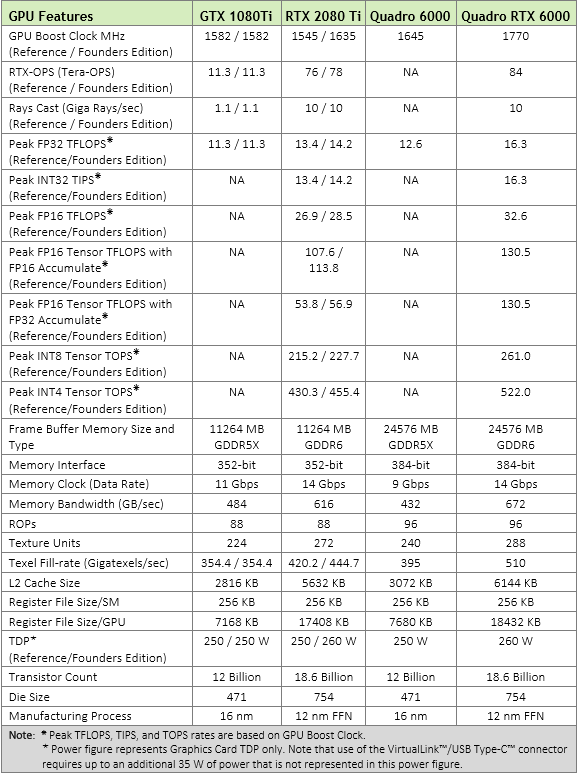

Det er altid rart at få de hårde data på bordet, og hvis man som hardcore entusiast sidder og nærstuderer tallene her, så vil man opdage, at RTX 2080 Ti har voldsomme boosts i antallet af TFLOPS og Tensor TFLOPS end tidligere GTX 1080 Ti kort.

Faktisk har RTX 2080 Ti hele 3 TFLOPS ekstra data at rykke rundt med, når der skal renderes grafik til slutbrugeren og 103 TFLOPS Tensor performance end 1080 Ti. Slutteligt har 2080 Ti sine RT Cores, der giver 10 GIGA Rays Raytracing performance. Da vi endnu ikke har noget sammenligneligt, er det heller ikke nemt at fortælle, hvad det kommer til at betyde for fremtidens performance.

NVIDIA har udstyret os med screenshots fra kendte spiltitler som Metro: Exodus, Star Wars, Tomb Raider og Assetto, og hvis det vi kan se på billeder er, hvad vi kan forvente i fremtiden, så har vi hidtil uset eye candy i vente. Reflektioner, skygger og detaljer er så livagtige ned til mindste detalje, så det kan være direkte svært at se, at der er tale om et spil.

Ny Streaming Multiprocessor (SM)

NVIDIAs nyeste Turing SM arkitektur er ifølge NVIDIA selv så fintrimmet, at den med sin nye shading teknologi kan levere 50% performance forbedring i forhold til tidligere Pascal arkitektur. Først og fremmest er forbedringen opnået ved at ændre på GPU chippens opbygning, så datavejen er forbedret, og der kan derved eksekveres flere opreationer i kernerne, end Pascal var i stand til, da der her blev en blokade/flaskehals. Derudover er datavejen i chippens hukommelse blevet optimeret i forhold til at forene den delte hukommelse, texture caching og hukommelsens load cache i en og samme enhed, hvilket sammenlagt fordobler båndbredden og L1 cachen til at udføre flere operationer på en gang.

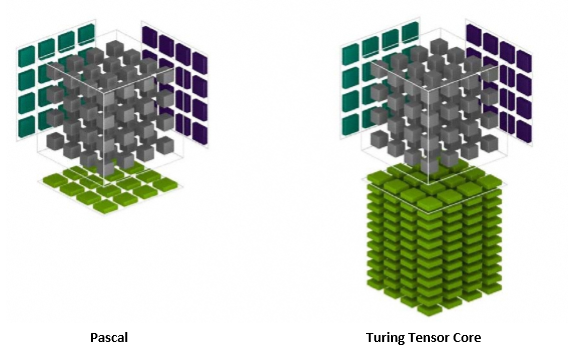

Turing Tensor Cores

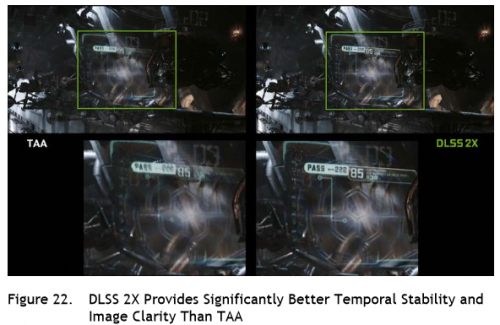

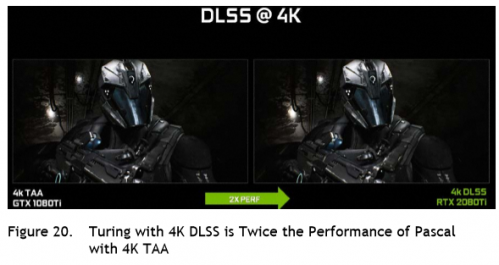

Turing Tensor Cores er kernen i AI teknologien, der gemmer sig i Turing SM systemet. Med Turing har NVIDIA indført INT8- og INT4 modes, der kan udføre AI handlinger, som ikke kræver dybere processering. NVIDIA kalder teknologien Deep Learning Super Sampling (DLSS), og den er drevet af kortenes Tensor Cores. DLSS suger data ud af flere frames og kombinerer dem til én højopløselig frame med uhyre flotte 3D detaljer, der ender hos os som slutbrugere.

Deep Learning Super Sampling (DLSS)

DLSS er i bund og grund en videreudvikling af TAA (Anti-Aliasing), hvilket er en grafisk proces til at forbedre et billede. Problemet med TAA er, at det har en tendens til at være svært for udviklere at bruge i praksis, hvilket ofte medfører pixelfejl i komplekse frames. Derfor har NVIDIA brygget videre på idéen og skabt DLSS. DLSS gør det samme, men i stedet for at gøre som TAA, der først renderer det endelige billede og derefter samler frames og endvidere, så gør DLSS processerne løbende i real-time og samler en given frame til sidst med samme kvalitet som TAA men med det halve shading arbejde.

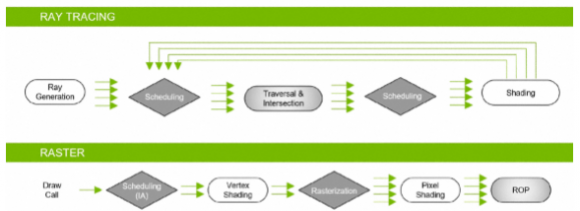

Real Time Raytracing Acceleration

Turing introducerer os for verdens mest avancerede grafiske rendering, der går under navnet Raytracing. En teknologi, som vi har ventet med længsel, siden NVIDIA annoncerede, at GTX navnet blev erstattet med RTX. De nye RT Cores anvender en hel ny proces i samarbejde med API's såsom Microsoft DirectX DXR, NVIDIA OptiX og Vulkan Raytracing til at skabe 100% virkelighedstro reflektioner, skygger, detaljer og generelle indtryk, der får en til at tro, at der er tale om en film og ikke et computerspil. Lidt i stil med Dolbys nyeste Vision teknologi, der giver hidtil usete grafiske oplevelser på film.

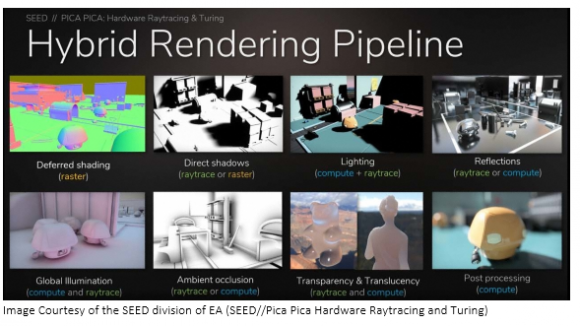

Hybrid Rendering Pipeline

Hybrid Rendering Pipeline er en proces i Raytracing teknologien, hvor der bliver kørt to separate processer til at udføre RT delen. Her vil Rasterization og Z-Buffering blive udført separat, da denne del kan gennemføres relativt hurtigt. Så kan den sekundære Raytracing pipeline bruges til at rendere og indskyde ekstra rays for at skabe et endnu mere realistisk billede.

Som anvist kører de to pipelines simultant og i samarbejde via Hybrid Rendering Pipeline. Vi skal ifølge NVIDIA ikke forvente hundredevis af rays pr. frame, men i stedet skal vi regne med at se langt færre. Antallet vil selvfølgelig afhænge af kompleksiteten af den pågældende frame. For at optimere Raytracing teknologien har NVIDIA udviklet Denoising Filter Modules, som frasorter støj i vores rays, hvilket essentielt skulle nedbringe antallet af nødvendige rays for stadig at kunne levere et formidabelt resultat.

Mesh Shading

NVIDIA har optimeret shading processen af opbygning af en frame ved at aflaste ens CPU fra tunge processer som Vertex, Tesselation og Geometry Shading, der alle er en del af den grafiske pipeline. Derved optimeres pipelinen ved at hive de shading opgaver ind i GPU kernen og udføre dem med en langt højere båndbredde, da en GPU chip arbejder anderledes end en CPU. GPU'en kan udføre mange af den samme proces på én gang, hvorimod CPU'en udfører mange ens processer efter hinanden og derved bliver en flaskehals for den samlede pipeline.

Variable Rate Shading (VRS)

Variable Rate Shading er en teknologi, der giver grafiske udviklere og spilproducenter mulighed for at lade grafikkortet køre en lavere processering af grafiske områder, hvor den fulde pipeline ikke ville give et bedre grafisk resultat, og derved opnå en samlet bedre shading under tilblivelsen af en frame.

Texture-Space Shading

Med Texture Space Shading bliver et ofte anvendt objekt rendered i sin egen pipeline og gemt direkte i grafikkortets hukommelse, hvor andre pixel shaders så kan hive objektet ud af hukommelsen fremfor at skulle kalde på det samme objekt igen, der derved skulle renderes endnu engang. Endnu en optimering, der booster den samlede pipeline, når en frame bliver skabt.

GDDR6 High Performance Hukommelse

Turing SM systemet er den første grafiske arkitektur, der gør nytte af de nye GDDR6 VRAM, der kommer med en 20% performance forbedring end de tidligere anvendte GDDR5 VRAM.

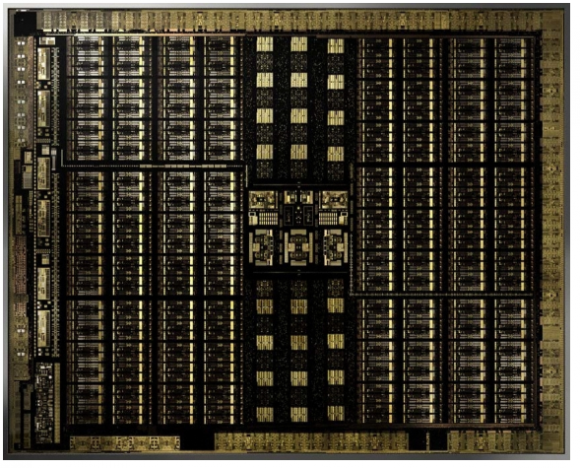

Turing TU102 GPU

TU102 GPU chippen kommer med følgende opsætning:

- 4608 CUDA Cores

- 72 RT Cores

- 576 Tensor Cores

- 288 Texture Units

- 12 32-bit GDDR6 memory controllers (Samlet 384-bits interface)

Til hver eneste memory controller er der tilknyttet 8 ROP's og 512 KB L2 cache. Samlet set er TU102 chippen udstyret med 96 ROP enheder og 6144 KB L2 cache

Chippen er, som I kan se, bygget op med en fælles L2 cache, der er forbundet til hver sin kerne, som er opbygget over et givet antal Tensor Cores, RT Cores, CUDA cores og Texture Units. Omkring kernerne ligger alle 12 memory controllers, der sørger for en høj båndbredde til kommunikation mellem den lynhurtige GDDR6 hukommelse, TU102 chippen og det resterende system. Når en pipeline er gennemført, og en frame er blevet skabt, sendes frames gennem en high speed hub og videre til slutbrugeren.

Her ser vi chippen med dens 18,6 milliarder transistorer, som udgør det samlede system af forskellige cores, cache og hukommelsescontrollere.

Som vi kan se med sammenlignings skemaet ovenfor, så bringer NVIDIA RTX 2080(Ti) en generelt performance forbedring med sig, og i den sammenhæng forventer vi da også at se en positiv forbedring i performance. Hvad vi skal forvente os af Raytracing teknologien må så lade vente på sig endnu. Lige nu venter vi på, at spilproducenterne får optimeret teknologien og implementeret ordentligt i fremtidige opdatering til deres spil.

NGX Software Architecture

NGX Architecture er en del af RTX kortenens AI system. NGX er inkorporeret i NVIDIA driveren, og det kommunikerer med GTX 2080(Ti) kortet. NVIDIA NGX er en del af NVIDIA GeForce Experience pakken, og når softwaren detekterer et Turing grafikkort, bliver der automatisk installeret NGX softwaren. NGX kan kommunikere med CUDA 10, DirectX og Vulkan drivere, og det kan også gøre brug af NVIDIA TensorRT, og processen acceleres af Turings Tensor Cores.

Seneste grafikkort

-

13 auggrafikkort

-

20 margrafikkort

ASRock RX 9070 Steel Legend

-

ASRock B580 Steel Legend

-

ASUS fremviser nye AMD RX 9700 grafikkort

-

ASUS klar med stort udvalg af RTX 50 grafikkort

-

07 jangrafikkort

Nvidia Reflex 2 reducerer gaming latency

-

07 jangrafikkort

Nvidia lancerer DLSS 4 med den nye RTX 50 serie

-

07 jangrafikkort

Nvidia RTX 50 serien er klar